Dans le paysage technologique en constante évolution de 2025, l’Event Sourcing se démarque comme une solution incontournable pour les entreprises cherchant à améliorer la gestion de leurs données. En effet, l’intégration d’architectures modernes, telles que celles basées sur Kafka, permet d’optimiser la traçabilité des événements tout en assurant une latence minimale. Cet article explore en profondeur les raisons pour lesquelles vous devriez envisager l’adoption de cette approche avant-gardiste.

Comprendre l’Event Sourcing et son intégration avec Kafka

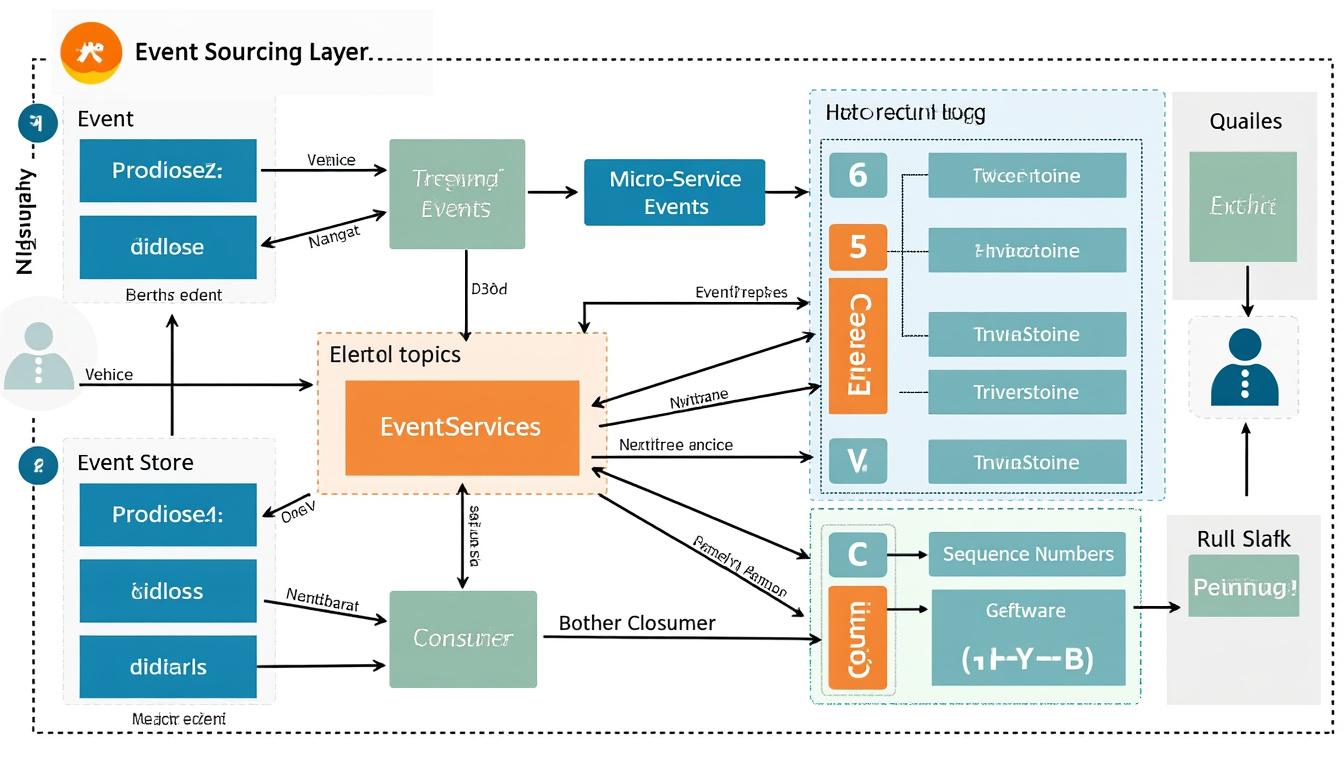

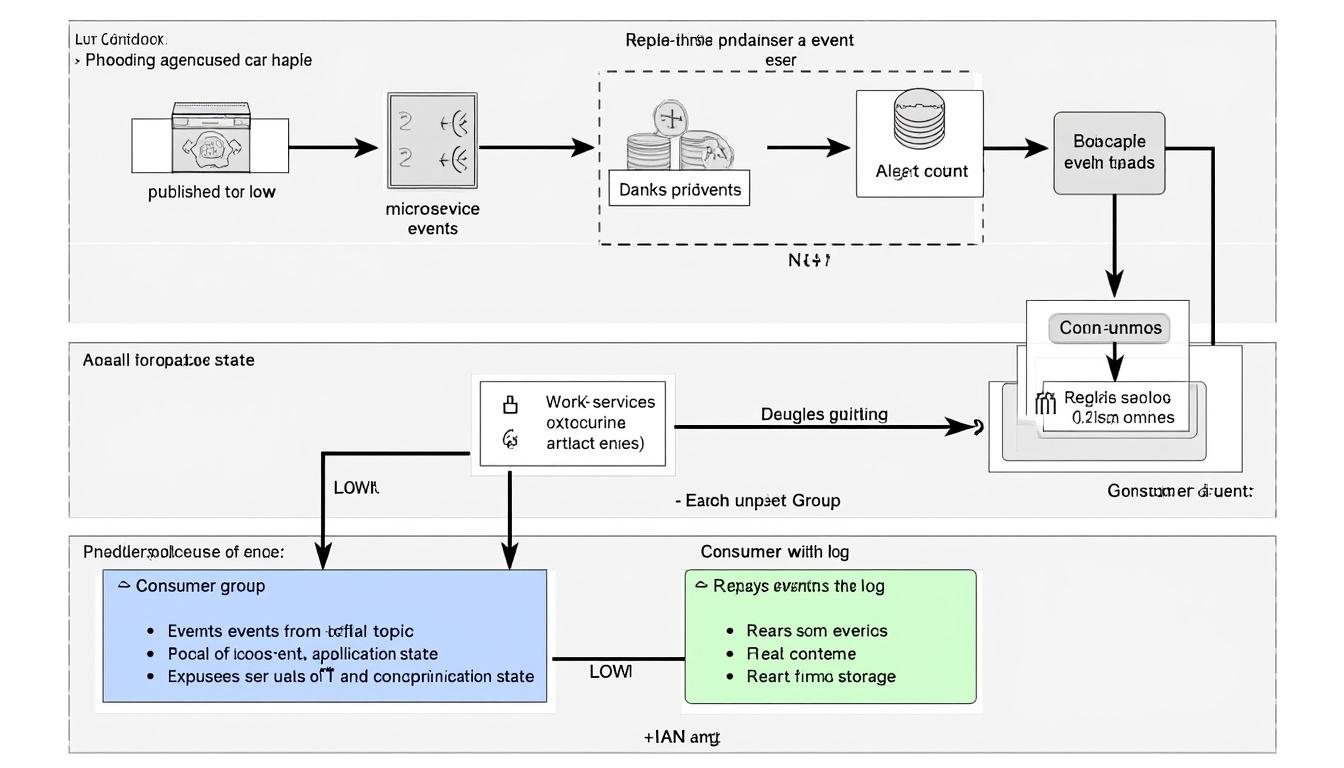

Event Sourcing est un modèle architectural où chaque changement d’état au sein d’une application est capturé comme un événement unique. Contrairement à la gestion traditionnelle des données, où les données sont mises à jour directement dans la base de données, ici chaque événement est persistant et peut être utilisé pour reconstruire l’état de l’application à tout moment. Cela permet également de retrouver l’historique complet des changements de manière rigoureuse.

Dans le cadre des architectures modernes, Kafka, une plateforme de streaming distribuée, joue un rôle central. Cette technologie permet de gérer des flux de données en temps réel, ce qui la rend particulièrement adaptée aux environnements qui requièrent scalabilité et résilience. Grâce à Kafka, les événements peuvent être publiés dans des thèmes et consommés par divers services, rendant l’intégration de l’Event Sourcing à la fois fluide et efficace.

Les avantages d’Event Sourcing avec Kafka

Adopter l’Event Sourcing avec Kafka présente plusieurs avantages significatifs :

- Traçabilité des événements : Chaque action dans le système laisse une trace, permettant ainsi de revenir en arrière pour comprendre les changements.

- Résilience : L’architecture décentralisée garantit que même en cas de panne, le système global reste opérationnel.

- Auditabilité : Facilite la création d’audits complets, essentiels pour se conformer aux normes réglementaires.

- Scalabilité : Kafka permet de gérer efficacement des volumes de données massifs sans compromission des performances.

- Flexibilité : Les nouveaux services peuvent être ajoutés sans perturber l’architecture existante.

Performance et gestion des données améliorées

À l’ère du Big Data, la vitesse de traitement est primordiale. La combinaison d’Event Sourcing et de Kafka permet d’atteindre des performances élevées tout en utilisant les ressources de manière optimale. L’architecture distribuée de Kafka évite les goulets d’étranglement, garantissant une gestion des données fluides et rapides.

De plus, les systèmes construits autour de ces technologies sont capables de maintenir une latence très basse, essentielle pour des applications en temps réel. Par exemple, dans une application de commerce électronique, chaque clic et chaque mouvement utilisateur pourrait être traité instantanément, enrichissant ainsi l’expérience client.

| Caractéristique | Impact sur la performance |

|---|---|

| Latence | Consommation en temps réel, analyse immédiate des données |

| Scalabilité horizontale | Ajout de nouveaux nœuds sans impact sur les performances existantes |

| Partitionnement des données | Traite simultanément de multiples flux d’informations |

Faciliter le développement logiciel avec l’Event Sourcing

Intégrer l’Event Sourcing dans le cycle de développement logiciel favorise une approche modulaire. Chacune des parties de l’application peut être développée et déployée indépendamment, ce qui facilite non seulement le travail des développeurs mais aussi celui des équipes de maintenance. En conséquence, cette séparation des préoccupations réduit le risque d’erreurs lors des mises à jour de systèmes existants.

Les architectures microservices fonctionnent particulièrement bien en conjonction avec l’Event Sourcing et Kafka. Chaque microservice peut être conçu pour réagir à des événements spécifiques et communiquer avec d’autres services via des flux de données Kafka. Cela renforce l’autonomie de chaque service et optimise l’utilisation des ressources.

API et intégration transparente

La création d’APIs qui consomment et produisent des événements devient un jeu d’enfant. Les équipes peuvent rapidement itérer et améliorer les fonctionnalités sans avoir à gestionner une base de données complexe. Cela favorise l’adoption de pratiques telles que le test TDD (Test-Driven Development), qui corrèle parfaitement avec les concepts d’Event Sourcing. Voici quelques étapes clés pour intégrer l’Event Sourcing dans votre processus de développement :

- Définir clairement les événements à capturer et leur structure.

- Implanter des producteurs d’événements qui envoient des messages dans Kafka.

- Développer des consommateurs qui réagissent à ces événements.

- Mettre en œuvre des tests pour garantir le bon fonctionnement et la cohérence des données.

- Déployer progressivement et collecter des retours pour optimiser le système.

Un avenir prometteur avec l’Event Sourcing et Kafka

Alors que la technologie continue d’évoluer, l’importance d’adopter des architectures modernes ne peut être sous-estimée. Les entreprises souhaitant évoluer dans un environnement à haute performance et résilience doivent considérer l’Event Sourcing et Kafka comme des éléments centraux de leur stratégie de transformation numérique.

Avec la montée de l’IoT, de l’intelligence artificielle et des systèmes cloud, l’échange rapide et sécurisé des données devient indispensable. En utilisant Kafka pour gérer les événements, les organisations peuvent garantir que chaque interaction utilisateur est stockée, analysée et utilisée pour prendre de meilleures décisions stratégiques.

| Élément | Importance pour l’architecture moderne |

|---|---|

| Traçabilité des événements | Indispensable pour l’audit et la conformité |

| Résilience | Facilite la continuité des opérations en cas de panne |

| Intégration avec des systèmes externes | Permet la collaboration et l’interopérabilité des données |

FAQ sur l’Event Sourcing et Kafka

Qu’est-ce que l’Event Sourcing ?

L’Event Sourcing est une approche qui capture toutes les modifications d’état d’une application sous forme d’événements. Cela permet de reconstruire l’état de l’application à tout moment.

Pourquoi choisir Kafka comme plateforme pour l’Event Sourcing ?

Kafka offre une architecture distribuée, une faible latence et une scalabilité élevée, ce qui en fait une solution optimale pour gérer des flux d’événements à grande échelle.

Quelles sont les meilleures pratiques pour implémenter l’Event Sourcing ?

Il est recommandé de définir clairement les événements à capturer, d’utiliser des producteurs et consommateurs Kafka appropriés, ainsi que de s’assurer que des tests rigoureux sont effectués pendant le développement.

L’Event Sourcing a-t-il des inconvénients ?

Bien que l’Event Sourcing offre de nombreux avantages, sa complexité peut augmenter, et il nécessite une gestion minutieuse des événements pour éviter les erreurs lors de la reconstitution des états.

Comment l’Event Sourcing peut-il améliorer la traçabilité des données ?

Chaque événement est enregistré dans le système, permettant ainsi d’accéder à un historique complet des changements, ce qui est essentiel pour l’audit et la conformité.

Commentaires